Mentre noi, poveri stolti, continuiamo a regalare le foto nostre e dei nostri amici e parenti a chiunque si inventi un trucchetto da quattro soldi, l’Intelligenza Artificiale le analizza con dei criteri sempre più nazisti. Per ora il fatalismo impera, ma nel frattempo Kate Crawford, artista, professoressa e studiosa nell’ambito dell’intelligenza artificiale, e Trevor Paglen, artista e ricercatore, hanno messo in piedi questa mostra che analizza per la prima volta le immagini di training, quelle che vengono utilizzate per allenare le macchine a riconoscere e classificare.

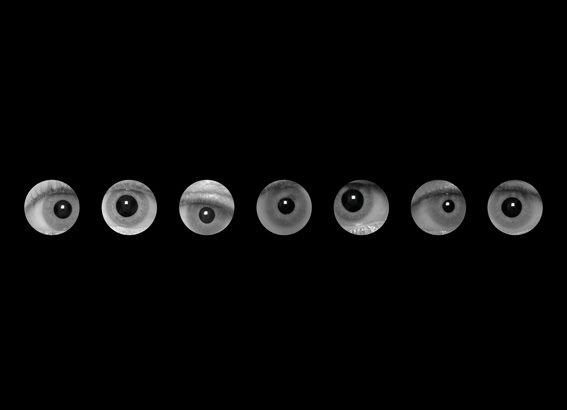

Esaminando la loro evoluzione storica, diventa evidente come più cresce la complessità, più aumentano i pregiudizi e le implicazioni politiche di queste classificazioni. E la dimensione più perturbante l’hanno trovata focalizzando la propria attenzione sui sistemi di classificazione basati sugli affetti e le emozioni – supportati dalle teorie molto criticate dello psicologo Paul Ekman, secondo il quale la varietà dei sentimenti umani può essere ridotta a sei stati emotivi universali.

Queste tecnologie d’intelligenza artificiale misurano le espressioni facciali delle persone per valutare una molteplicità di fattori: la loro salute mentale, la loro affidabilità come possibili nuovi assunti o la loro tendenza a commettere atti criminali. Chi, a questo punto, allena queste macchine? Con quali criteri è autorizzato a operare? Chi è autorizzato a trarne benefici? Qual è il confine tra scienza e politica, ancora una volta? Come sottolineano gli artisti: “un’asimmetria di potere è propria di questi strumenti. La nostra speranza è che Training Humans segni il punto di partenza per iniziare a ripensare questi sistemi e per comprendere in modo scientifico come ci vedono e ci classificano”.

Scritto da Black Mamba